Узнайте как выглядел сайт в прошлом. и о том, как изменялись популярные сайты за 20 лет

Содержание:

- Как пользоваться веб архивом

- Чем будет полезен веб-архив для вас

- Как выглядели культовые сайты раньше

- Чем может грозить отсутствие копии в Яндексе

- Работа с результатами

- Разбираем на примере как правильно подойти к оценке первичной информации

- Сайт студента-программиста

- Плюсы и минусы продвижения сателлитами

- r-tools.org

- Примечания

- Что такое веб-архив и зачем он нужен?

- История создания архива интернета

- Как посмотреть удаленную страницу в веб-архиве

- Первый сайт в зоне .ru

- Уникальный контент из веб-архива

- r-tools.org

- Специальные программы для скачивания сайтов

- Альтернативы сохраненной копии Яндекса

- Удаление страницы через справочный центр

- Что такое кеш сайта и зачем он нужен

- YouTube

- Что такое исходящие ссылки

- Макеты из архива, как бюджетное решение для нового проекта

Как пользоваться веб архивом

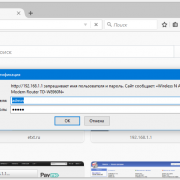

Если вы хотите выполнить поиск в архиве веб-страниц, введите в адресную строку вашего браузера адрес web.archive.org.ru, после чего в поле поиска укажите адрес интересуемого сайта. Например, введите адрес домашней страницы Яндекса http://yandex.ru и нажмите клавишу «Enter».

Сохраненные копии главной страницы Яндекс на сайте web.archive.org

Зелеными кружочками обозначены даты когда была проиндексирована страница, нажав на него вы перейдете на архивную копию сайта. Для того чтобы выбрать архивную дату, достаточно кликнуть по временной диаграмме по разделу с годом и выбрать доступные в этом году месяц и число. Так же если вы нажмете на ссылку «Summary of yandex.ru» то увидите, какой контент был проиндексирован и сохранен в архиве для конкретного сайта с 1 января 1996 года ( это дата начала работы веб архива).

Какой контент сохраняет веб-архив интернета

Нажав на выбранную дату, вам откроется архивная копия страницы, такая как она выглядела на веб-сайте в прошлом. Давайте посмотрим на Яндекс в молодости, ниже приведен снимок главной страницы Яндекса на 8 февраля 1999 года.

Веб архив копия сайта Яндекс на 08.02.1999

Вполне возможно, что в архивном варианте страниц, хранящемся на веб-сайте Archive.org, будут отсутствовать некоторые иллюстрации, и возможны ошибки форматирования текста. Это результатом того, что механизм архивирования веб-сайтов, пытается, прежде всего, сохранить текстовый контент web-сайтов. Помните об еще одном ограничении онлайн-архива. При поиске конкретного контента, размещенного на определенной архивной странице, лучше всего вводить ее точный адрес, а не главный адрес данного веб-сайта.

Возвращаясь к нашему примеру: вы получили доступ к архивному контенту, размещенному на главной странице Яндекса, при нажатии на ссылки в архивной версии могут как загружаться так и не загружаться другие страницы сайта. Так в нашем варианте страница «последние 20 запросов» была найдена, а вот страница «Реклама на yandex.ru» не нашлась.

Подводя итоги можно сказать, что web.archive.org поистине уникальный и грандиозный проект. Он действительно является машиной времени для интернета, позволяя найти удаленные сайты и их архивные версии . Как использовать предоставляемые возможности решать только вам, но использовать их можно и нужно обязательно !

Чем будет полезен веб-архив для вас

Данный сервис годится не только для того, чтобы смотреть, в каком состоянии была ваша страничка или любой другой ресурс некоторое время назад. С его помощью вы можете восстановить свой сайт, его страницу, какой-то текст или элемент, если вдруг по какой-то причине данные были стерты. Чтобы этого не произошло, не забывайте почаще выполнять резервное копирование вашего сайта, ну, а на экстренный случай имейте в виду WebArchive. Но имейте в виду также, что WebArchive делает снимки по своему усмотрению с непредсказуемой частотой, поэтому нужной вам версии сайта в нем может и не оказаться.

Вручную восстанавливать ресурс из веб-архива очень долго и для этого нужно неплохо разбираться в сайтостроении и верстке. Однако при желании восстановление можно автоматизировать при помощи онлайн-инструмента ARCHIVARIX.

До 200 файлов сервис восстанавливает бесплатно, а при большем количестве взимает небольшую плату.

Веб-архив может быть вам полезен и тем, что он содержит колоссальное количество уникальных текстов, которые опубликованы на канувших в небытие ресурсах. Как это можно использовать с выгодой для своего бизнеса? Допустим, вы запускаете сайт. Сами писать тексты не можете из-за отсутствия времени, а на оплату услуг копирайтера денег нет. Чтобы не откладывать запуск проекта, попробуйте найти уникальный контент в Wayback Machine.

Найдите любой сайт, близкий вашему по тематике, откройте его содержимое, скопируйте тексты и прогоните их через софт или сервис проверки на плагиат. Статьи, которые окажутся уникальными (от 90% и выше), вы можете без зазрения совести опубликовать на своем сайте. Это не будет считаться хищением, так как тексты после удаления ресурсов стали ничейными.

Для поиска таких сайтов можно использовать базы хостинговых компаний. Обычно они публикуют список тех доменов, срок действия которых истек или вот-вот истечет. Существуют и специальные программы, которые ищут освободившиеся домены по нужным параметрам.

Как выглядели культовые сайты раньше

Для примера посмотрим, как выглядели популярные ресурсы раньше, а именно Яндекс, Google, YouTube, Википедия и VK. Все из них с течением времени претерпели кардинальные изменения в дизайне.

Поисковик Яндекс

Поисковую систему Яндекс официально анонсировали 23 сентября 1997 года. С тех прошло более 20 лет, и сегодня это одна из самых популярных поисковых систем в мире.

В веб-архиве первая сохраненная копия датируется 6 декабря 1998 года.

На тот момент выглядел Яндекс вот так:

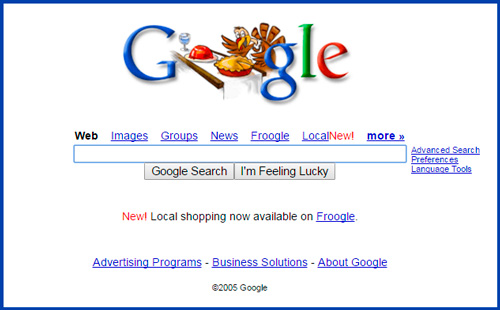

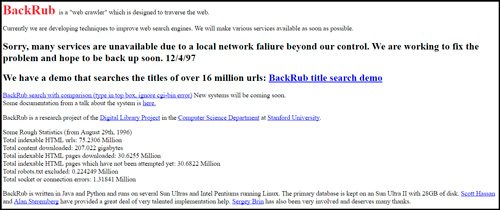

Поисковик Google

Поисковая система Google была основа чуть позже – в 1998 году. Сейчас это самая популярная поисковая система в мире.

Первые сохраненные копии появились в веб-архиве в конце 1998 года. Например, 2 декабря Гугл выглядел вот так:

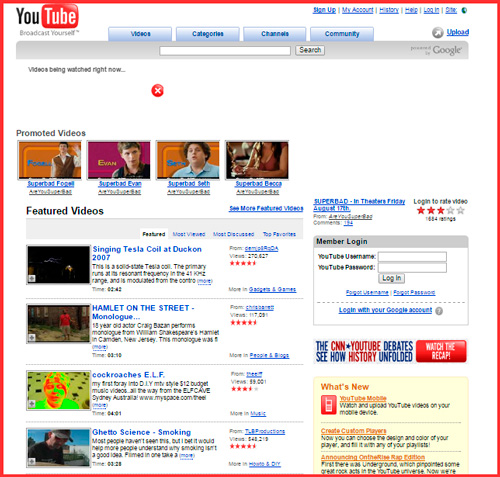

YouTube

Youtube начал свою работу в феврале 2005 года. Первые сохраненные в веб-архиве копии появились в конце апреля 2005 года. На то время сервис имел минималистичный дизайн, и видно, что он являлся не более, чем видеохостингом:

Википедия

Википедия появилась 15 января 2001 года. Сегодня она является наиболее крупным и популярным справочником в интернете и содержит более 40 миллионов статей, которые доступны на 301 языке.

В веб-архиве первая сохраненная копия Википедии датируется 27 июля 2001 года:

Популярная в России и других странах социальная сеть ВКонтакте была создана 10 октября 2006 года.

В веб-архиве первая сохраненная копия сайта датируется 8 ноября 2006 года. На нём видно, что сайт изначально был ориентирован на студентов и выпускников.

Чем может грозить отсутствие копии в Яндексе

Само по себе отсутствие копии не будет влиять как-то негативно на продвижение. А вот причины, которые привели к отсутствию могут повредить, поэтому разберитесь с ними.

Чем действительно может обернуться проблема с копиями страниц, так это затруднениями при работе с биржами ссылок.

Например, в Сеопульте сегодня есть параметр, который осуществляет контроль над тем, есть ли сохраненная копия Яндексе. Данный параметр называется NIC — No Index Cache. Он свидетельствует о том, что страница не имеет сохраненной копии. С такого ресурса не будут покупать ссылки, никому не хочется рисковать и платить за то, что может не принести пользы.

Как вы видите, сохраненная копия в Яндексе позволяет решить ряд проблем и оптимизировать использование интернет-трафика. Данные рекомендации позволят оперативно открывать и просматривать их.

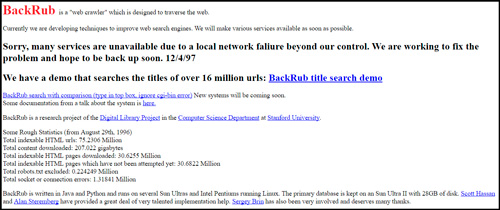

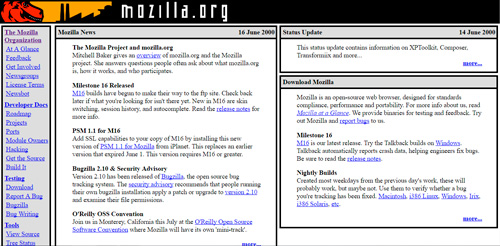

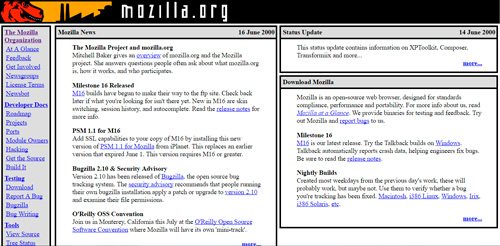

Изначально, популярнейший поисковик Гугл назывался BackRub. И выглядел как-то стрёмно и совершенно непонятно.

Лишь в 1998 он принял более современный внешний вид. Тогда еще, в конце слова Google стоял восклицательный знак. Представляете, это бета версия, то есть тестовая. Тогда еще разработчики исправляли ошибки и проверяли как все работает. Эх, где мои 16 лет.

Уже тогда здесь было две кнопки. Одна со стандартным поиском, а вторая выбирает случайную страницу с информацией. Если бы администраторы убрали кнопку «Мне повезет», которая пользуется бешенной популярностью и по сей день, то смогли бы получать дополнительный доход с рекламы. Он составил бы примерно 100 миллионов долларов в год. Но, они не жадные.

Кстати о деньгах, компания Mozilla ежегодно получает от гугла 300 миллионов за то, что в их браузере по умолчанию стоит поисковая система от Google.

Работа с результатами

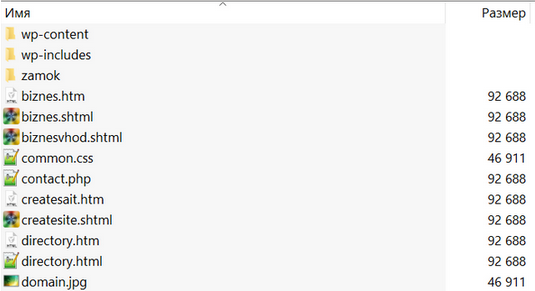

После запуска, задачи появится на листинге в разделе “Восстановление из Вебархива”. Вы можете проследить за статусом его выполнения. Когда задача будет готова появится кнопка “Скачать”, с помощью которой вы сможете скачать ZIP-архив с копией сайта на свой компьютер и потом загрузить его на хостинг.

Чтобы перейти в задачу и просмотреть результаты, просто нажмите на название задачи. Перед вами откроется список скачанных файлов со столбцами:

- Название файла

- Тип файлов

- Дата сохранения

- Действия

Этот список вы можете отсортировать по любому столбцу. Также присутствует форма поиска по названию файла. Вы можете воспользоваться пагинацией или указать сколько результатов выводить на странице.

Вы можете кликнуть по URL-адресам выгруженных файлов — они доступны для просмотра и открываются в новой вкладке (откроется уже сохраненная на нашем сервере копия).

Если какие-то страницы скачались неправильно или не те, то для каждой из них можно выбрать другую дату копии, для этого нужно нажать в колонке “Действия” на иконку редактирования. Чуть подождав, откроется окно с выбором дат, за которые в Вебархиве есть копии. Нужно всего лишь установить чекбокс на дату, которая интересует:

Если других дат нет — значит в Вебархиве не содержится дополнительных копий выбранной страницы.

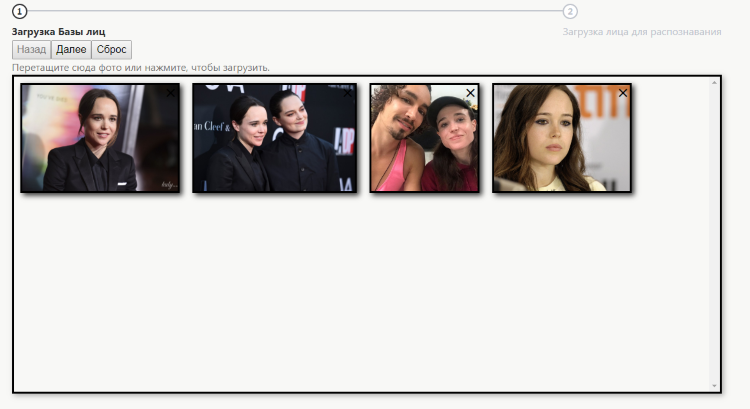

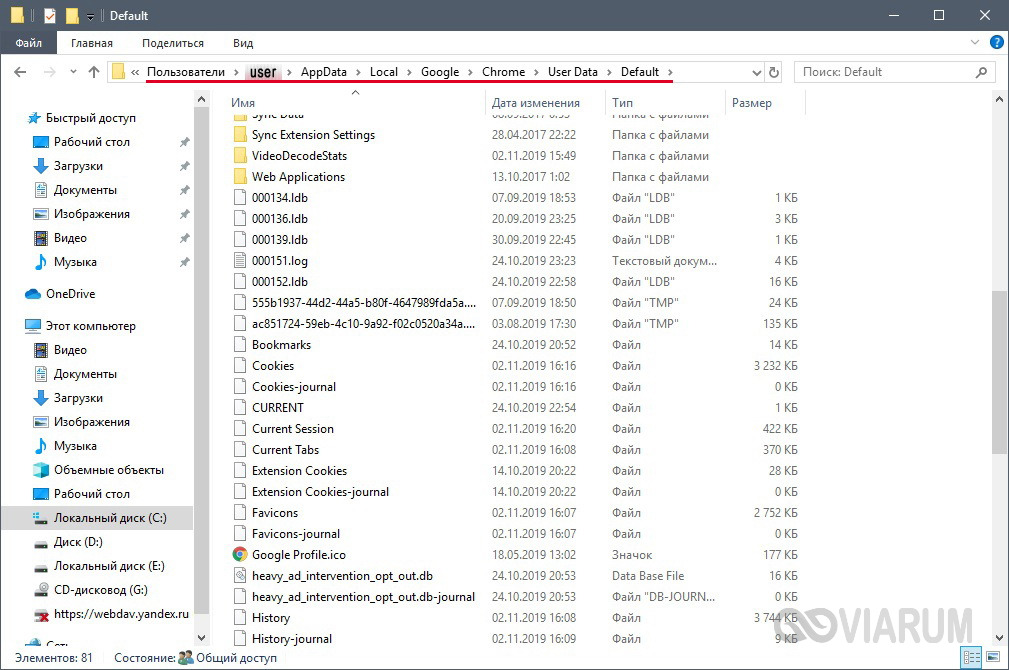

Дальше, чтобы восстановить сайт на своем сервере скачиваем ZIP-архив c задачи, просматриваем его и распаковываем по FTP в корневую директорию своего домена на хостинге:

После запуска сайта внимательно просмотрите как он работает, пройдитесь по всем страницам, проверьте работоспособность всех ссылок, кнопок, отображение стилей и картинок, так как бывает что в Вебархиве присутствуют не все страницы сайта и нужно что-то подправить.

Разбираем на примере как правильно подойти к оценке первичной информации

Возьмем всем известный ресурс — cian.ru. Вводим домен в текстовое поле на нашей странице и получаем информацию представленную ниже на скриншоте. Выбираем 2010 год.

Количество HTML страниц = 630. Что это означает? Это значит, что за 2010 год веб-архив увидел 630 уникальные страницы. При этом, если главная страница менялась например 30 раз, то для нас будет уже 600 уникальных страниц. Тоесть по сути это может быть и 200 страниц, но они обновляемые и поэтому считаются как уникальные.

* При восстановлении сайта у нас, мы берем самую последнюю версию страницы, т.к. невозможно сохранить например 2 главные страницы и на них ссылаться. Поэтому сайт будет наиболее полным и ничего не потеряется. Все зависит от того сколько к себе сохранил на сервер веб-архив.

Бывают ситуации, когда в начале года был старый сайт, а в середине года изменился на новый: поменяли дизайн, структуру ссылок и т.д. В данном случае все страницы посчитаются как уникальные, и при восстановлении нужно указывать последнюю версию с тем дизайном, который вам нужен.

Так как реально оценить сколько уникальных (для пользователя) страниц не предоставляется возможным, то мы предоставляем то суммарное количество файлов больше которого точно сайт не будет. Да, это не совсем корректная оценка, но хотя бы приблизительно можно понять размеры ресурса.

492 039 HTML страниц — это сумма страниц за все годы.

Надеемся, что все вышеописанное не будет сложным для понимания и снимет множество вопросов. Если есть вопросы относящиеся к данной теме, но не описанные в статье — пишите нам на почту, с радостью ответим.

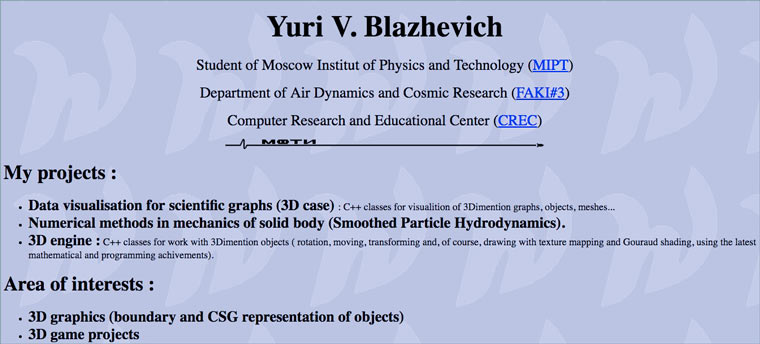

Сайт студента-программиста

Домашние страницы «Я Миша, я живу в Нью-Йорке, у меня есть кот» — основа русскоязычного интернета тех лет. Такие сайты создали эмигранты, которые искали общения с бывшими соотечественниками. До 1997 года личных страниц именно жителей России было еще мало.

Например, 22-летний Юрий Блажевич из МФТИ выкладывал на сайте свое резюме и написанные им программы для создания 3D-графики. Там же он рассказывал о своих интересах и собирал ссылки на полезные интернет-сайты.

Через несколько лет парень смог сделать хорошую карьеру и стал ведущим программистом в популярной игре «Блицкриг 2». Но, к сожалению, ушел из жизни в 2007 году.

Сохраненная страница: 7 октября 1997 года.

Плюсы и минусы продвижения сателлитами

Преимущества продвижения с помощью сайтов-сателлитов очевидны:

- Удобный способ поддерживать качественную ссылочную массу

- Вы не зависите от рыночных цен на размещение ссылок

- Продвижение несколько проектов с помощью одной сети сателлитов

- Размещение рекламных блоков, покрывающих часть затрат на создание сети

- Есть возможность вытеснить конкурентов из выдачи по ключевым запросам

Недостатки такого метода продвижения:

- Высокая стоимость создания сети сателлитов, куда войдут регистрация домена и хостинга, подготовка контента

- Высокие временные затраты на создание сайта, разработку контента, продвижение

- Есть шанс попасть под пессимизацию Яндекс и Google при создании недостаточно трастовых ресурсов

r-tools.org

Первое, что бросается в глаза дизайн сайта стороват. Ребята, пора обновлять!

Плюсы:

- Подходит для парсинга сайтов у которых мало html страниц и много ресурсов другого типа. Потомучто они рассчитывают цену по html страницам

- возможность отказаться от сайта, если качество не устроило. После того как система скачала сайт, вы можете сделать предпросмотр и отказаться если качество не устроило, но только если еще не заказали генерацию архива. (Не проверял эту функцию лично, и не могу сказать на сколько хорошо реализован предпросмотр, но в теории это плюс)

- Внедрена быстрая интеграция сайта с биржей SAPE

- Интерфейс на русском языке

Минусы:

- Есть демо-доступ — это плюс, но я попробовал сделать 4 задания и не получил никакого результата.

- Высокие цены. Парсинг 25000 стр. обойдется в 2475 руб. , а например на Архивариксе 17$. Нужно учесть, что r-tools считает html страницы, архиварикс файлы. Но даже если из всех файлов за 17$ только половина html страницы, все равно у r-tools выходит дороже. (нужно оговориться, что считал при $=70руб. И возможна ситуация, когда r-tools будет выгоден написал про это в плюсах)

Примечания

- (англ.). Alexa Internet. — Глобальный рейтинг сайта archive.org. Дата обращения: 20 июня 2020.

- .

- .

- (англ.). archive.org. Дата обращения: 28 марта 2019.

- . Internet Archive (7 мая 2007). Дата обращения: 31 августа 2016.

- (недоступная ссылка). Wayback Machine (6 июня 2000). Дата обращения: 1 сентября 2016.

- Jeff. (Blog). Wayback Machine Forum. Internet Archive (23 сентября 2002). Дата обращения: 4 января 2007. Author and Date indicate initiation of forum thread

- Miller, Ernest (Blog). LawMeme. Yale Law School (24 сентября). Дата обращения: 4 января 2007. The posting is billed as a ‘feature’ and lacks an associated year designation; comments by other contributors appear after the ‘feature’

- Maximillian Dornseif. (англ.). preprint cs/0404005 16. arXiv (2004). Дата обращения: 26 ноября 2017.

- .

- .

- (недоступная ссылка). Дата обращения: 17 сентября 2017.

- . Роскомнадзор (24 октября 2014).

- ↑

Что такое веб-архив и зачем он нужен?

Веб-архив — история миллионов сайтов

Веб-архив — это специализированный сайт, который предназначен для сбора информации о различных интернет-ресурсах. Робот осуществляет сохранение копии проектов в автоматическом и ручном режиме, все зависит лишь от площадки и системы сбора данных.

На текущий момент имеется несколько десятков сайтов со схожей механикой и задачами. Некоторые из них считаются частными, другие — открытыми для общественности некоммерческими проектами. Также ресурсы отличаются друг от друга частотой посещения, полнотой сохраняемой информации и возможностями использования полученной истории.

Как отмечают некоторые эксперты, страницы хранения информационных потоков считаются важной составляющей Web 2.0. То есть, частью идеологии развития сети интернет, которая находится в постоянной эволюции

Механика сбора весьма посредственная, но более продвинутых способов или аналогов не имеется. С использованием веб-архива можно решить несколько проблем: отслеживание информации во времени, восстановление утраченного сайта, поиск информации.

История создания архива интернета

Wayback Machine является одним из двух главных проектов archive.org. Этот некоммерческий сервис был создан в 1996 году Брюстером Кейлом. Машина времени сайтов имеет четкую цель: сбор и хранение копий ресурсов вместе со всем контентом для возможности свободного просмотра несуществующих или неподдерживающихся страниц в будущем. С 1999-го робот стал фиксировать еще и аудио, видео, иллюстрации, программное обеспечение.

База современного архива собиралась в течение 20 лет, у нее не существует аналогов. Статистика впечатляет: на сегодняшний день в сервисе находится 279 миллиардов страниц, 11 миллионов книг и статей, 100 тысяч программ и миллион картинок.

А знаете ли вы? Веб-архив сайтов часто имеет проблемы на законодательном уровне из-за нарушения авторских прав. По требованию правообладателей библиотека удаляет материалы из публичного доступа.

Как посмотреть удаленную страницу в веб-архиве

Веб-архив – это специальный сервис, который хранит на своем сервере данные со всех страниц, которые есть в интернете. Даже, если сайт перестанет существовать, то его копия все равно останется жить в этом хранилище.

В архиве также хранятся все версии интернет страниц. С помощью календаря разрешено смотреть, как выглядел тот или иной сайт в разное время.

В веб-архиве можно найти и удаленные страницы с ВК. Для этого необходимо выполнить следующие действия.

- Зайти на сайт https://archive.org/.

- В верхнем блоке поиска ввести адрес страницы, которая вам нужна. Скопировать его из адресной строки браузера, зайдя на удаленный аккаунт ВК.

Используя интернет-архив вы, естественно, не сможете написать сообщение, также как узнать когда пользователь был в сети. Но посмотреть его последние добавленные записи и фото очень даже можно.

Страница найдена

Если искомая страница сохранена на сервере веб-архива, то он выдаст вам результат в виде календарного графика. На нем будут отмечены дни, в которые вносились изменения, добавлялась или удалялась информация с профиля ВК.

Выберите дату, которая вам необходима, чтобы увидеть, как выглядела страница. Используйте стрелочки «вперед» и «назад», чтобы смотреть следующий или предыдущий день либо вернитесь на первую страницу поиска и выберите подходящее число в календаре.

Страница не найдена

Может случиться, что необходимая страница не нашлась на сайте WayBackMachine. Это не значит, что вы что-то сделали не правильно, такое часто случается. Возможно, аккаунт пользователя был закрыт от поисковиков и посторонних сайтов и поэтому не попал в архив. WayBackMachine самый популярный сайт, но он не единственный в своем роде. Попробуйте найти в Яндексе или Гугле другие веб-архиви. Искомая страница могла сохраниться на их серверах.

Попытайте удачу в поисках архивной версии профиля на этих сайтах:

- archive.is;

- webcitation.org;

- freezepage.com;

- perma.cc.

Также обязательно попробуйте найти страничку на русскоязычном аналоге http://web-arhive.ru/.

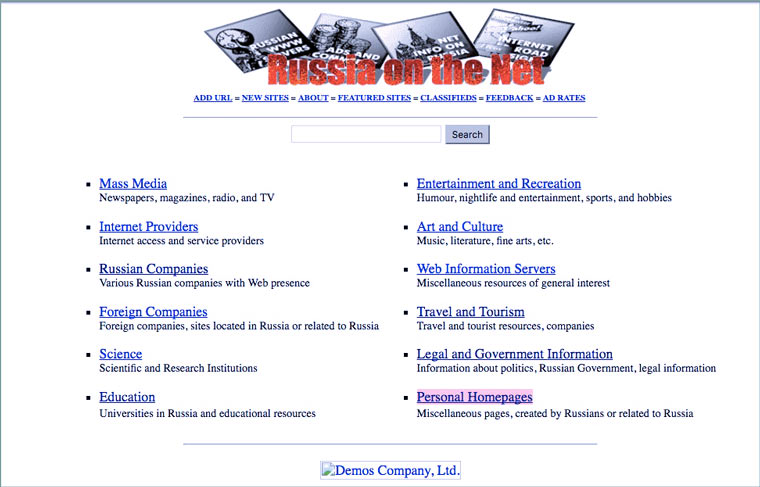

Первый сайт в зоне .ru

7 апреля 1994 года был зарегистрирован домен .ru. Вскоре на нем был размещен сайт http://www.ru, который назывался Russia on the Net. Это был каталог ссылок на русскоязычные страницы и англоязычные сайты отечественных компаний.

Создали этот сайт в фирме «Демос», бывшим программистском кооперативе, существовавшем с 1989 года. Ранее они участвовали в создании первой отечественной компьютерной сети «Релком» и регистрации доменной зоны .su, в которой с 1990 по 1994 год было размещено более 1000 сайтов (в основном научных учреждений).

К сожалению, найти первые сайты в зоне .su сейчас сложно и, поэтому, статья будет о первых сайтах в зоне .ru, которые засветились во Всемирном Архиве Интернета (основан в 1996 году).

Сохраненная страница: 14 ноября 1996 года.

Уникальный контент из веб-архива

Многие коммерческие сайты через некоторое время существования закрываются. Если на них был опубликован полезный контент (экспертные статьи, аналитические обзоры и другая важная информация), то после закрытия первоисточника они могут быть востребованными. То есть, сайт уже не работает и ранее написанные статьи могут использоваться на информационных порталах (если они уникальны).

Веб-архив является очень полезным сервисом, который может пригодиться в различных ситуациях. Быстрое восстановление потерянных данных может значительно сэкономить время и финансы, если сайт подвергнется хакерской атаке или же перестанет работать из-за серьезной технической проблемы. Веб-архив дает возможность не только просматривать старые версии своего сайта, но и анализировать контент конкурентов, сохраненный в разные периоды времени.

r-tools.org

Первое, что бросается в глаза дизайн сайта стороват. Ребята, пора обновлять!

Плюсы:

- Подходит для парсинга сайтов у которых мало html страниц и много ресурсов другого типа. Потомучто они рассчитывают цену по html страницам

- возможность отказаться от сайта, если качество не устроило. После того как система скачала сайт, вы можете сделать предпросмотр и отказаться если качество не устроило, но только если еще не заказали генерацию архива. (Не проверял эту функцию лично, и не могу сказать на сколько хорошо реализован предпросмотр, но в теории это плюс)

- Внедрена быстрая интеграция сайта с биржей SAPE

- Интерфейс на русском языке

Минусы:

- Есть демо-доступ — это плюс, но я попробовал сделать 4 задания и не получил никакого результата.

- Высокие цены. Парсинг 25000 стр. обойдется в 2475 руб. , а например на Архивариксе 17$. Нужно учесть, что r-tools считает html страницы, архиварикс файлы. Но даже если из всех файлов за 17$ только половина html страницы, все равно у r-tools выходит дороже. (нужно оговориться, что считал при $=70руб. И возможна ситуация, когда r-tools будет выгоден написал про это в плюсах)

Специальные программы для скачивания сайтов

Разработчики приложений создают специальные программы, которые позволяют быстро скачать необходимый сайт в интернете. Для этого нужно знать, какие утилиты лучше применять, принципы их работы и прочие нюансы.

HTTrack WebSite Copier

Это приложение является лучшим среди бесплатных программ для сохранения интернет-страничек в оффлайн режиме. Скачать его можно с официального сайта разработчика или на других порталах.

Как пользоваться утилитой:

- для начала нужно скачать приложение на компьютер, установить и запустить;

- появится окно с настройками, где нужно будет выбрать язык, среди перечисленных вариантов выделяем русский;

- после этого откроется окно, где нужно подписать проект, указать категорию и место для загрузки сайта;

- далее, в специальной графе вводим адрес самого сайта для скачивания.

Через несколько минут программа автоматически загрузит все данные из веб-страницы в указанную папку на компьютере. Информация будет доступна в off-line режиме в файле index.htm.

Сама по себе утилита проста в использовании, интерфейс несложный, сможет разобраться любой пользователь. Есть возможность настроить программу под себя, например, запретить скачивать картинки с сайта или отметить только желаемые страницы. Среди плюсов можно выделить: бесплатную версию, простой интерфейс, быстрое сохранение сайта. Минусов не обнаружено, так как утилита имеет большое количество положительных отзывов со всего мира.

Teleport Pro

Продолжает список лучших программ Teleport Pro. Это одно из самых старых приложений, которое позволяет скачать сайт на компьютер. По сравнению с прошлой утилитой, эта программа платная, ее стоимость на официальном портале составляет $50. Для тех, кто не хочет платить, есть тестовая версия, которая даст возможность пользоваться приложением определенный период времени.

После скачивания и установки откроется главное окно утилиты, там нужно указать параметры для сохранения сайта. Предлагается выбрать такие варианты: сохранить загружаемую копию, дублировать портал, включая структуру, сохранить определенный тип файлов, сохранить все интернет-ресурсы, связанные с источником, загрузить файлы по указанным адресам, скачать страницы по ключевым словам.

Далее создается новый проект, где указывается адрес самого сайта, а также папка для сохранения данных. Чтобы запустить программу, нужно нажать на кнопку «Start». Оффлайн доступ к файлам сайта будет открыт уже через несколько минут.

https://youtube.com/watch?v=Q3n9vsrE9P4

Положительные стороны приложения – простота в использовании, удобное и быстрое скачивание. Среди минусов стоит выделить платную версию, которую смогут купить далеко не все пользователи.

Offline Explorer Pro

На этом список программ для скачивания сайтов не заканчиваются. Есть еще одна платная утилита, которая имеет большое количество функций и возможностей. На официальном сайте можно скачать бесплатную версию, но она будет иметь ряд ограничений на сохранение файлов. Полная версия приложения делиться на три пакета: Standard, Pro и Enterprise. Стоимость стандартной утилиты обойдется в $60, а с расширением Pro – $600.

Как и в большинстве программ, процесс скачивания начинается с создания нового проекта. Там вводится название, веб-адрес, необходимая папка на компьютере. Также сеть большое количество настроек, которые позволяют скачать только самую нужную информацию. Предлагается сохранить только текст или с картинками. Программисты и разработчики сайтов точно ее оценят.

После регулировки параметров нужно нажать на кнопку «Загрузка», и утилита начнет сохранять файлы на ПК. Скачивание длится недолго, уже через несколько минут данные сайта будут в папке. Преимущества – многофункциональность, доступна русская версия, быстрая загрузка. Недостатки – только платная версия, которая стоит недешево.

Webcopier

Еще одно платное приложение, которое имеет бесплатную версию, действующую 15 дней. Процесс работы похож на предыдущие программы. Необходимо создать новый проект, заполнить информацию о сайте, ввести адрес и указать папку для загрузки. Нажатие кнопки «Start download» позволит запустить работу утилиты. Скорость скачивания среднее, ниже, чем у других программ. Приобрести полную версию можно за $40.

Плюсы – приятный интерфейс, удобные настройки, простое управление.

Минусы – платная версия.

Альтернативы сохраненной копии Яндекса

Яндекс — не единственный поисковик в мире. Просто он лучше адаптирован и ориентирован больше на русскоязычный сегмент интернета. Тем не менее, всегда есть альтернативные способы найти копию своего сайта в интернете:

- Google. Полный аналог Яндекс и по функционалу, и по возможности найти резервную копию сайта. Найти ее можно точно так же, как в российском поисковике — нажав стрелочку рядом с выбранным пунктом выдачи и открыв пункт «Сохраненная копия».

- Web.archive.org. Огромная база сохраненных сайтов с просторов всего интернета. Вероятность попадания туда относительно молодого сайта крайне мала, однако она есть.

- CachedView.com. Это поисковик по сохраненным копиям на различных ресурсах, в том числе и в Google.

Естественно, не стоит игнорировать и менее известные поисковые системы. Это может быть Рамблер, Yahoo, поиск от Mail.ru, Bing, Апорт. Возможно, кто-то из них закэшировал нужный веб-ресурс.

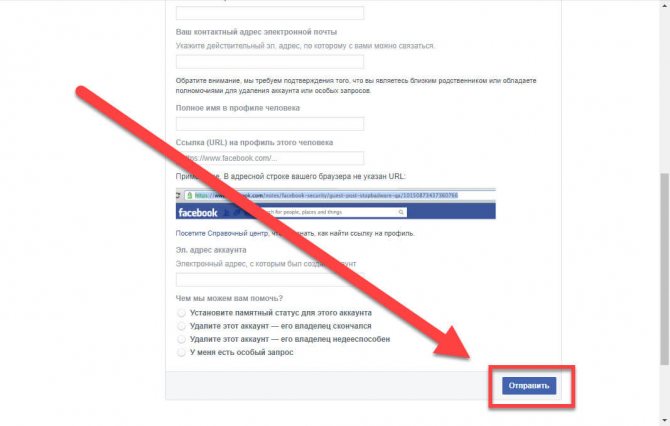

Удаление страницы через справочный центр

Предыдущие способы не помогли избавиться от страницы? Не переживайте, остался ещё один неплохой вариант. Его обычно используют для удаления аккаунтов родственников или друзей, которые самостоятельно войти в профиль уже не могут. Но что мешает нам использовать такой вариант лично для себя? Правильно, ничего! Тогда приступаем к инструкции:

- Открываем страницу справочного центра Facebook.

- Находим вкладку «Управление аккаунтом» и нажимаем по ней.

- В выпадающем меню выбираем «Деактивация или удаление аккаунта».

- Открывается страница с самыми популярными запросами в техническую поддержку. Кликаем по последнему вопросу.

- В тексте находим гиперссылку «Подайте заявку здесь» и переходим по ней.

- Заполняем необходимую информацию, такую как имя и фамилию, адрес электронной почты, ссылку на наш аккаунт и полное название профиля.

- В конце выбираем «Отправить».

Теперь только остаётся дождаться ответа от технической поддержки. А они его могут формировать на протяжении нескольких дней или даже недель. Так что запаситесь терпением!

Что такое кеш сайта и зачем он нужен

Поисковая система Google оснащена так называемыми ботами, которые регулярно посещают страницы сайтов и сохраняют их в памяти поисковика. Это и есть кеш, в котором сохраненная копия сайта остается даже в том случае, если сам ресурс был удален. Следует отметить, что боты «гуляют» по Интернету достаточно активно, поэтому информация в кеше, как правило, является актуальной. Однако есть два важных нюанса:

- Чем чаще на сайте появляются новые публикации, тем чаще его посещает бот, а значит, данные будут максимально свежими.

- Нередко случается так, что после удаления статьи с сайта по этой ссылке пользователь видит сообщение об ошибке. Однако бот успел посетить эту пустую страницу и сохранил ее в кеш, удалив прошлую актуальную версию.

Разобравшись с особенностями работы кеша Google, стоит понять, для чего поисковая система хранит в памяти старые версии сайтов. Эксперты приводят несколько серьезных аргументов:

- Страница с материалами была удалена с сайта, а вам срочно нужны именно эти данные.

- Часть информации в нужной публикации была изменена на другие материалы.

- Владелец сайта удалил его или закрыл доступ для пользователей.

- Сайт слишком перегружен, в результате чего страницы загружаются долго.

- На сайт обрушилась ддос-атака, поэтому данные оказались временно заблокированы.

- Программисты проводят технические работы, в результате чего открыть нужную страницу невозможно.

Очевидно, что главная причина поиска сохраненных страниц заключается в утерянной информации и попытке восстановить ее с помощью функционала Google. И если с причинами и особенностями кеширования все понятно, можно переходить к главному вопросу: как посмотреть старую версию сайта и сохранить нужные сведения.

YouTube

Компания YouTube открылась 14 февраля, в день всех влюбленных. В России же его начали использовать лишь в 2007 году, а первым выложенным роликом стала песня Петра Налича «Гитар». С той поры прошло 10 лет.

Если бы ютуб был не видеохостингом, а кинокомпанией, то каждую неделю они смогли бы выпускать по 60 тысяч фильмов. Материала для этого предостаточно.

Кстати, сейчас у ютуба столько же посетителей, сколько было пользователей в интернете в целом в 2000 году. Ежедневно ролики набирают около 2 миллиарда просмотров.

YouTube не только стал одной из самых популярных компаний, но еще и делает знаменитыми простых людей. Многим россиянам известны такие люди как Макс Голопогосов (+100500), Рома Желудь, BadComedian, mrFreeman. А вот певица Адель и Джастин Бибер получили всемирную славу благодаря этой социальной сети. Я уже молчу о том, сколько людей благодаря ним смогли разбогатеть.

Что такое исходящие ссылки

Для начала, немного теории и терминов. В SEO часто упоминаются два субъекта — донор и акцептор. Донор — это сайт, с которого ведет ссылка, акцептор, соответственно — сайт, на который ссылается донор. Исходящие ссылки — это линки, ведущие с сайта-донора на сайт-акцептор. Все очень просто. При добавлении на сайт исходящих ссылок, нужно руководствоваться некоторыми правилами и здравым смыслом. При чем здесь смысл, может спросить неопытный вебмастер? Да при том, что современные сеошники очень часто боятся исходящих ссылок, считая их вселенским злом, и пытаясь непременно закрыть от индексации даже ссылки на соцсети. Все это ерунда. Исходящие ссылки никакого вреда не несут, если сайт-акцептор — тематический, анкоры — некоммерческие, общий уровень заспамленности сайта-донора — невысокий. Более, того, ссылаясь на авторитетные ресурсы, вы только поднимете уровень доверия поисковиков к вашему ресурсу. Также, следует понимать, что если сайт — , то ни входящие, ни исходящие ссылки не помогут, нужно удалить все папочки с сервера, и не забыть про базу данных хотя бы довести его до ума в плане внутренней оптимизации.

Изначально, популярнейший поисковик Гугл назывался BackRub. И выглядел как-то стрёмно и совершенно непонятно.

Лишь в 1998 он принял более современный внешний вид. Тогда еще, в конце слова Google стоял восклицательный знак. Представляете, это бета версия, то есть тестовая. Тогда еще разработчики исправляли ошибки и проверяли как все работает. Эх, где мои 16 лет.

Уже тогда здесь было две кнопки. Одна со стандартным поиском, а вторая выбирает случайную страницу с информацией. Если бы администраторы убрали кнопку «Мне повезет», которая пользуется бешенной популярностью и по сей день, то смогли бы получать дополнительный доход с рекламы. Он составил бы примерно 100 миллионов долларов в год. Но, они не жадные.

Кстати о деньгах, компания Mozilla ежегодно получает от гугла 300 миллионов за то, что в их браузере по умолчанию стоит поисковая система от Google.

Макеты из архива, как бюджетное решение для нового проекта

Очень много встречается лэндингов (landing page). Сейчас существует множество сервисов предлагающих за арендную плату воспользоваться конструктором для построения целевых страниц под контекстную рекламу. Но зачем платить ежемесячно, когда можно заплатить один раз и получить готовое решение, проверенное кем-то на практике. Более того, если на сайте были установлены счетчики, вы можете их восстановить на своем аккаунте и посмотреть какой трафик был в прошлом.

Макеты можно использовать как уникальный дизайн для своего веб-проекта. И в итоге он может оказаться ничем не хуже чем дизайн за $1000. А тем более учитывая стоимость восстановления в ~$4, вы получаете его уже с готовой html-версткой.